Danger en exemple de l’intelligence artificielle : les risques de l’IA

Introduction : danger en exemple de l’intelligence artificielle

L’intelligence artificielle est partout. Dans les outils bureautiques, les plateformes pédagogiques, la gestion des emails, le marketing, la relation client. Pour beaucoup de professionnels, elle représente un gain de temps considérable. Pourtant, derrière ces bénéfices visibles, les dangers de l’intelligence artificielle sont rarement abordés de manière concrète.

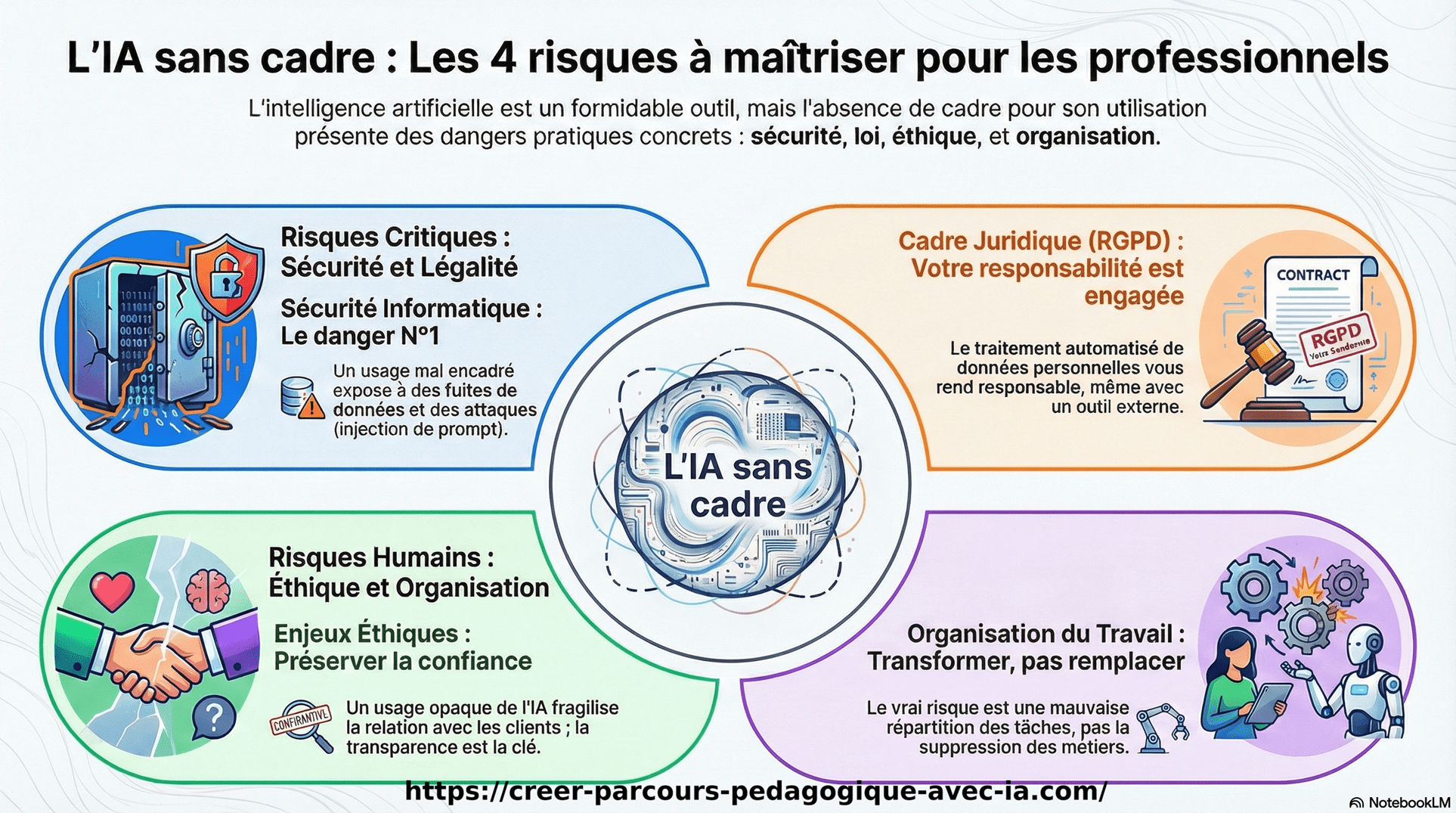

Quand on parle de danger de l’IA, il ne s’agit pas de scénarios de science‑fiction ni de machines qui domineraient l’humanité. Les dangers de l’IA sont aujourd’hui beaucoup plus terre à terre. Ils concernent la sécurité des données, la conformité juridique, la responsabilité humaine et l’organisation du travail.

En tant qu’enseignante et formatrice indépendante, j’utilise l’IA comme outil d’aide, notamment pour automatiser certaines tâches administratives. Mais j’ai rapidement compris une chose essentielle : le danger de l’intelligence artificielle n’est pas l’outil lui‑même, mais l’absence de cadre.

C’est pour cette raison que je souhaite revenir ici sur les dangers de l’intelligence artificielle, avec des exemples concrets issus du terrain. L’objectif n’est pas de faire peur, mais de permettre une utilisation lucide, responsable et maîtrisée de l’IA, en particulier pour les indépendants, enseignants et formateurs.

Dans la suite de cet article, je vais analyser les principaux dangers de l’IA en entreprise, expliquer pourquoi certains usages peuvent devenir problématiques, et surtout montrer comment limiter ces risques sans renoncer aux bénéfices de l’automatisation.

Introduction : Pourquoi parler du danger de l’IA plutôt que de ses promesses

L’intelligence artificielle est partout. Dans les outils bureautiques, les plateformes pédagogiques, la gestion des emails, le marketing, la relation client. Pour beaucoup de professionnels, elle représente un gain de temps considérable. Pourtant, derrière ces bénéfices visibles, les dangers de l’intelligence artificielle sont rarement abordés de manière concrète.

Quand on parle de danger de l’IA, il ne s’agit pas de scénarios de science-fiction ni de machines qui domineraient l’humanité. Les dangers de l’IA sont aujourd’hui beaucoup plus terre à terre. Ils concernent la sécurité des données, la conformité juridique, la responsabilité humaine et l’organisation du travail.

En tant qu’enseignante et formatrice indépendante, j’utilise l’IA comme outil d’aide, notamment pour automatiser certaines tâches administratives. Mais j’ai rapidement compris une chose essentielle : le danger de l’intelligence artificielle n’est pas l’outil lui-même, mais l’absence de cadre.

C’est pour cette raison que je souhaite revenir ici sur les dangers de l’intelligence artificielle, avec des exemples concrets issus du terrain. L’objectif n’est pas de faire peur, mais de permettre une utilisation lucide, responsable et maîtrisée de l’IA, en particulier pour les indépendants, enseignants et formateurs.

Dans la suite de cet article, je vais analyser les principaux dangers de l’IA en entreprise, expliquer pourquoi certains usages peuvent devenir problématiques, et surtout montrer comment limiter ces risques sans renoncer aux bénéfices de l’automatisation.

Pourquoi parler des dangers de l’intelligence artificielle plutôt que de ses promesses

Le discours autour de l’IA est souvent centré sur la performance et le gain de temps. Pourtant, ignorer les dangers de l’intelligence artificielle revient à construire des usages fragiles et difficilement soutenables sur le long terme.

Le danger de l’IA ne vient pas de la technologie en elle-même, mais de son intégration rapide dans des processus professionnels sans cadre clair. C’est ce manque de réflexion en amont qui expose aux erreurs, aux dérives et aux risques juridiques.

Parler des dangers de l’IA, c’est donc rééquilibrer le débat. Il s’agit d’identifier les limites réelles, les conséquences concrètes et les impacts humains avant de généraliser les usages.

Ces requêtes traduisent une attente claire : comprendre les risques réels avant d’adopter l’IA à grande échelle.

Dans les sections suivantes, je vais détailler les principaux dangers de l’intelligence artificielle, en partant des plus critiques pour aller vers les enjeux organisationnels et humains.

Dans quel ordre analyser les dangers de l’IA en entreprise

Lorsqu’on parle de dangers de l’intelligence artificielle, l’erreur la plus fréquente est de tout mélanger. Tous les risques n’ont ni le même niveau d’urgence, ni le même impact. Certes l’utilisation des outils IA permet d’aider à bien organiser son temps (comme je l’explique dans mon précédent article), mais ils ne sont pas une fin en soi. C’est pourquoi l’ordre d’analyse est déterminant.

Pour un usage professionnel de l’IA, notamment chez les indépendants et les formateurs, je recommande de raisonner du plus critique au plus structurant.

Danger en exemple de l’intelligence artificielle : Sécurité informatique

C’est le premier danger de l’IA à traiter. Un usage mal encadré peut exposer l’entreprise à des fuites de données, à des détournements de consignes ou à des attaques indirectes, notamment via des techniques comme l’injection de prompt. Tant que ce point n’est pas maîtrisé, le reste est secondaire.

Danger en exemple de l’intelligence artificielle : Cadre juridique et RGPD

Une fois la sécurité posée, la question du droit devient centrale. Le traitement automatisé de données personnelles engage la responsabilité du professionnel. Les dangers de l’IA ici concernent la conformité, la transparence et la traçabilité des usages.

Danger en exemple de l’intelligence artificielle : Enjeux éthiques

Vient ensuite la dimension éthique. Le danger de l’intelligence artificielle est de créer une relation opaque avec les clients ou les apprenants. Informer clairement sur l’usage de l’IA permet de préserver la confiance.

Danger en exemple de l’intelligence artificielle : Ressources humaines et organisation du travail

Enfin, l’impact sur le travail humain. Contrairement aux idées reçues, les dangers de l’IA ne sont pas la suppression des métiers, mais une mauvaise répartition des tâches. L’IA modifie les rôles, elle ne remplace pas le jugement humain.

Exemple concret d’un danger de l’intelligence artificielle en situation réelle

Pour comprendre le danger de l’intelligence artificielle, rien n’est plus parlant qu’un exemple concret. Prenons un cas simple et très courant : l’automatisation des réponses aux emails avec un modèle de langage.

En tant qu’indépendant, il est tentant de confier à l’IA la lecture et la préparation des réponses aux messages entrants. Le danger de l’IA apparaît lorsque cette automatisation est mise en place sans règles strictes et sans validation humaine.

Dans ce contexte, l’IA analyse le contenu des emails reçus. Or, un message peut contenir des instructions dissimulées, volontairement ou non. Sans protection, le modèle peut intégrer ces éléments dans sa réponse ou modifier son comportement.

C’est un exemple de danger de l’intelligence artificielle très concret : l’outil ne fait qu’exécuter ce qu’il interprète, sans capacité de discernement. Le risque ne vient pas d’une intention malveillante de l’IA, mais d’un usage non encadré.

Ce type de situation illustre parfaitement pourquoi les dangers de l’IA sont aujourd’hui surtout liés aux pratiques professionnelles, et non à une hypothétique perte de contrôle globale.

Sécurité informatique : un danger majeur de l’intelligence artificielle

Parmi les dangers de l’intelligence artificielle, la sécurité informatique est souvent sous-estimée. Pourtant, c’est l’un des risques les plus immédiats dès que l’IA analyse des contenus externes, comme des emails ou des formulaires.

Le danger de l’IA apparaît lorsque le modèle reçoit des instructions cachées dans les données qu’il traite. On parle alors d’injection de prompt. Concrètement, un message peut tenter d’influencer le comportement de l’IA en lui donnant des consignes déguisées.

Sans cadre strict, l’IA peut produire des réponses inadaptées, divulguer des informations internes ou sortir du périmètre prévu. Ce danger de l’intelligence artificielle ne relève pas d’une faille technique, mais d’un usage mal sécurisé.

La règle est simple. L’IA doit être contrainte par des consignes claires, limitées, et systématiquement validées par un humain. Sans cette étape, les dangers de l’IA augmentent mécaniquement.

Ici encore, le risque ne vient pas de la technologie, mais de son intégration sans garde-fous.

Cadre juridique et RGPD : un danger souvent sous-estimé de l’IA

Parmi les dangers de l’intelligence artificielle, le cadre juridique est fréquemment traité trop tard. Dès lors que l’IA intervient dans le traitement d’emails, de formulaires ou de données clients, la responsabilité du professionnel est engagée.

Le danger de l’IA ici concerne le traitement automatisé de données personnelles. Même si l’outil est externe, c’est bien l’entreprise ou l’indépendant qui reste responsable au regard du RGPD.

Sans information claire des utilisateurs, ni politique de confidentialité à jour, les dangers de l’IA deviennent juridiques. Le risque n’est pas théorique. Il porte sur la conformité, la transparence et la traçabilité des traitements.

Une règle simple permet déjà de limiter ce danger de l’intelligence artificielle : informer explicitement que certains traitements peuvent être automatisés, et ne jamais déléguer la décision finale à l’IA.

Là encore, le problème ne vient pas de l’outil, mais d’un usage sans cadre légal clairement défini.

Enjeux éthiques : un danger de l’intelligence artificielle lié à la confiance

Les dangers de l’intelligence artificielle ne sont pas uniquement techniques ou juridiques. L’éthique joue un rôle central, notamment dans la relation de confiance avec les clients, les apprenants ou les partenaires.

Le danger de l’IA apparaît lorsque l’usage de l’automatisation devient opaque. Si une réponse est partiellement rédigée par une IA sans que cela soit assumé, la relation peut se fragiliser.

Utiliser l’IA ne signifie pas disparaître derrière un outil. Le danger de l’intelligence artificielle serait de déléguer la relation humaine elle-même, alors que l’IA doit rester un support, jamais un substitut.

Une transparence minimale suffit souvent à limiter les dangers de l’IA. Informer, valider, ajuster. L’humain reste responsable, l’IA assiste.

Dans ce cadre, l’éthique n’est pas un frein à l’automatisation. Elle en est la condition de durabilité.

Ressources humaines : un danger de l’IA souvent mal compris

Parmi les dangers de l’intelligence artificielle, l’impact sur l’emploi est l’un des plus sensibles. L’automatisation soulève une crainte légitime : celle de voir certaines fonctions disparaître.

Le danger de l’IA n’est pourtant pas la suppression des métiers, mais la confusion entre automatisation et remplacement. L’IA excelle dans les tâches répétitives et chronophages, pas dans la compréhension fine du contexte ni dans la relation humaine.

Dans les faits, les dangers de l’IA apparaissent lorsque l’on cherche à automatiser sans repenser l’organisation du travail. Sans clarification des rôles, l’outil devient source de tensions plutôt que de soulagement.

Utilisée correctement, l’IA transforme les tâches, pas la valeur humaine. Le danger de l’intelligence artificielle serait de croire qu’elle peut décider à la place de l’humain, alors qu’elle doit rester un levier d’aide.

Ici encore, la clé n’est pas technologique, mais organisationnelle.

FAQ Les dangers de l’intelligence artificielle avec exemples

Quels sont les risques de l’intelligence artificielle ?

Les risques de l’intelligence artificielle ne viennent pas d’une volonté malveillante de la machine. Ils viennent surtout de la manière dont on l’utilise.

Aujourd’hui, les principaux risques sont :

– automatiser trop vite sans vérifier les résultats,

– faire confiance à une réponse sans la comprendre,

– utiliser des données sensibles sans cadre clair,

– déléguer des décisions importantes à un outil qui ne comprend pas les conséquences.

L’IA exécute. Elle ne réfléchit pas. Le danger apparaît quand l’humain se retire du processus.

Quand l’IA va-t-elle dépasser l’humain ?

Sur certains points, c’est déjà le cas.

L’IA est plus rapide que l’humain pour :

– traiter de gros volumes d’informations,

– répéter la même tâche sans fatigue,

– appliquer des règles simples à grande échelle.

Mais elle ne dépasse pas l’humain sur :

– le jugement,

– la prise de recul,

– la responsabilité,

– l’éthique.

Dire que l’IA va remplacer l’humain est donc une simplification excessive. En réalité, elle remplace surtout des gestes mécaniques, pas la réflexion.

Quels sont les effets négatifs des biais de l’IA ?

Une IA apprend à partir de données existantes.

Si ces données sont biaisées, l’IA reproduit ces biais sans les questionner.

Concrètement, cela peut provoquer :

– des décisions injustes,

– des exclusions automatiques,

– des discriminations difficiles à détecter.

Le problème est que ces erreurs sont souvent invisibles, car l’IA donne une impression de neutralité. Or, elle ne fait que répéter ce qu’on lui a montré.

Pourquoi être contre l’intelligence artificielle ?

Être critique vis-à-vis de l’IA ne signifie pas refuser le progrès.

Beaucoup de personnes sont opposées à certains usages de l’IA parce qu’elles observent :

– un manque de transparence,

– des décisions automatiques impossibles à expliquer,

– une perte de contrôle humain,

– une responsabilité floue en cas d’erreur.

Le rejet ne vise pas l’outil, mais son utilisation sans règles claires.

Quels sont les points négatifs de l’IA ?

Les points négatifs les plus fréquents sont :

– une dépendance excessive aux outils,

– une perte de compétences humaines,

– une standardisation des réponses,

– une confiance aveugle dans des résultats parfois faux.

L’IA peut faire gagner du temps, mais elle peut aussi en faire perdre beaucoup si elle est mal utilisée.

Quels sont des exemples concrets d’intelligence artificielle ?

L’IA est déjà partout dans le quotidien professionnel :

– réponses automatiques aux emails,

– chatbots sur les sites web,

– outils de génération de texte ou d’images,

– systèmes de recommandation.

Ces outils sont utiles tant qu’ils restent assistés et contrôlés.

Quelles sont les IA considérées comme à haut risque ?

Les IA dites « à haut risque » sont celles qui ont un impact direct sur la vie des personnes.

Par exemple :

– recrutement et évaluation des candidats,

– décisions financières,

– diagnostic médical,

– surveillance.

Plus l’impact est fort, plus le contrôle humain doit être présent.

Quels métiers sont en danger avec l’IA ?

Les métiers les plus exposés sont ceux basés sur des tâches répétitives et prévisibles.

En revanche, les métiers qui demandent :

– de l’analyse,

– de l’adaptation,

– de la relation humaine,

– de la responsabilité,

évoluent plus qu’ils ne disparaissent.

Le vrai risque n’est pas l’IA, mais le fait de ne pas s’y adapter intelligemment.

Quels sont les deux pires risques de l’IA ?

La perte de contrôle liée à l’automatisation sans supervision et la mauvaise gestion des données personnelles.

Quel est un exemple négatif d’IA ?

Une IA qui répond automatiquement à des emails sensibles sans validation humaine, en appliquant des consignes cachées présentes dans le message.

Quand l’IA va dépasser l’humain ?

Elle dépasse déjà l’humain sur les tâches répétitives, mais pas sur le jugement ni la responsabilité.

Quels sont les réels dangers de l’intelligence artificielle à l’heure actuelle ?

Ils sont surtout organisationnels, juridiques et liés à la sécurité, plus que technologiques.

Quels sont les dangers de l’intelligence artificielle dans la santé ?

Le principal danger est l’utilisation d’outils automatisés sans validation médicale humaine.

Quels sont les inconvénients de l’intelligence artificielle dans l’éducation ?

Une dépendance aux outils et une perte de réflexion personnelle chez les apprenants.

L’IA représente-t-elle un danger pour l’homme ?

Elle devient un danger uniquement lorsqu’elle est utilisée sans cadre, sans transparence et sans contrôle humain.

Conclusion – Comprendre les dangers de l’intelligence artificielle pour mieux l’utiliser

Les dangers de l’intelligence artificielle ne relèvent pas d’un futur hypothétique ni d’une menace abstraite. Ils sont déjà bien réels et concernent avant tout la manière dont l’IA est intégrée dans les pratiques professionnelles.

Sécurité, cadre juridique, éthique et organisation du travail sont aujourd’hui les véritables points de vigilance. Le danger de l’IA n’est pas l’outil en lui-même, mais l’absence de règles, de supervision humaine et de réflexion en amont.

Utilisée avec méthode, l’IA reste un levier puissant pour gagner du temps et se recentrer sur son cœur de métier. Utilisée sans cadre, elle devient un facteur de risque.

Pour compléter cette réflexion, de nombreuses ressources permettent d’explorer les dangers de l’intelligence artificielle sous différents angles, qu’il s’agisse de documents PDF de synthèse, des inconvénients de l’intelligence artificielle dans les usages quotidiens, ou encore des risques spécifiques dans la santé.

D’autres analyses mettent en perspective les avantages et inconvénients de l’intelligence artificielle, notamment dans l’éducation, où les questions de dépendance aux outils et de standardisation des contenus sont centrales. Enfin, l’impact de l’intelligence artificielle sur l’environnement constitue un enjeu croissant, souvent sous-estimé, mais essentiel pour une adoption durable et responsable de ces technologies.

Et maintenant ?

Si vous avez l’impression de courir après le temps sans toujours savoir où concentrer vos efforts, ces mêmes outils IA peuvent quand même vous aider.

➡️ Prenez donc 2 minutes, pour identifier plus clairement vos priorités actuelles en tant que formateur, afin d’y voir plus clair sur ce qui mérite réellement votre attention en ce moment.

(Le sondage s’ouvre sur une nouvelle page, depuis votre smartphone.) Ou alors version ordinateur ci-dessous :

Ma vidéo sur les dangers de l’IA

Pour aller plus loin avec un exemple concret et une démonstration réelle, je détaille dans une vidéo comment l’automatisation des emails avec l’IA peut devenir un danger si elle est mal encadrée, et surtout comment la sécuriser dans un contexte d’enseignant ou de formateur indépendant :

Laisser un commentaire